فناوری نظامی عجیب آمریکا در عملیات دستگیری مادورو

به گفته منابع آگاه، ابزار هوش مصنوعی «کلود» متعلق به شرکت انتروپیک در عملیات نظامی آمریکا برای دستگیری نیکلاس مادورو در ونزوئلا استفاده شده است؛ موضوعی که نشان میدهد فناوری هوش مصنوعی با سرعتی چشمگیر در حال نفوذ به ساختارهای نظامی پنتاگون است.

به گزارش اقتصادآنلاین، به گفته افراد مطلع از موضوع، ابزار هوش مصنوعی «کلود» متعلق به شرکت انتروپیک در عملیات ارتش آمریکا برای بازداشت نیکلاس مادورو، رئیسجمهور پیشین ونزوئلا، مورد استفاده قرار گرفت؛ مسئلهای که نشان میدهد مدلهای هوش مصنوعی بهطور فزایندهای در پنتاگون جایگاه پیدا میکنند.

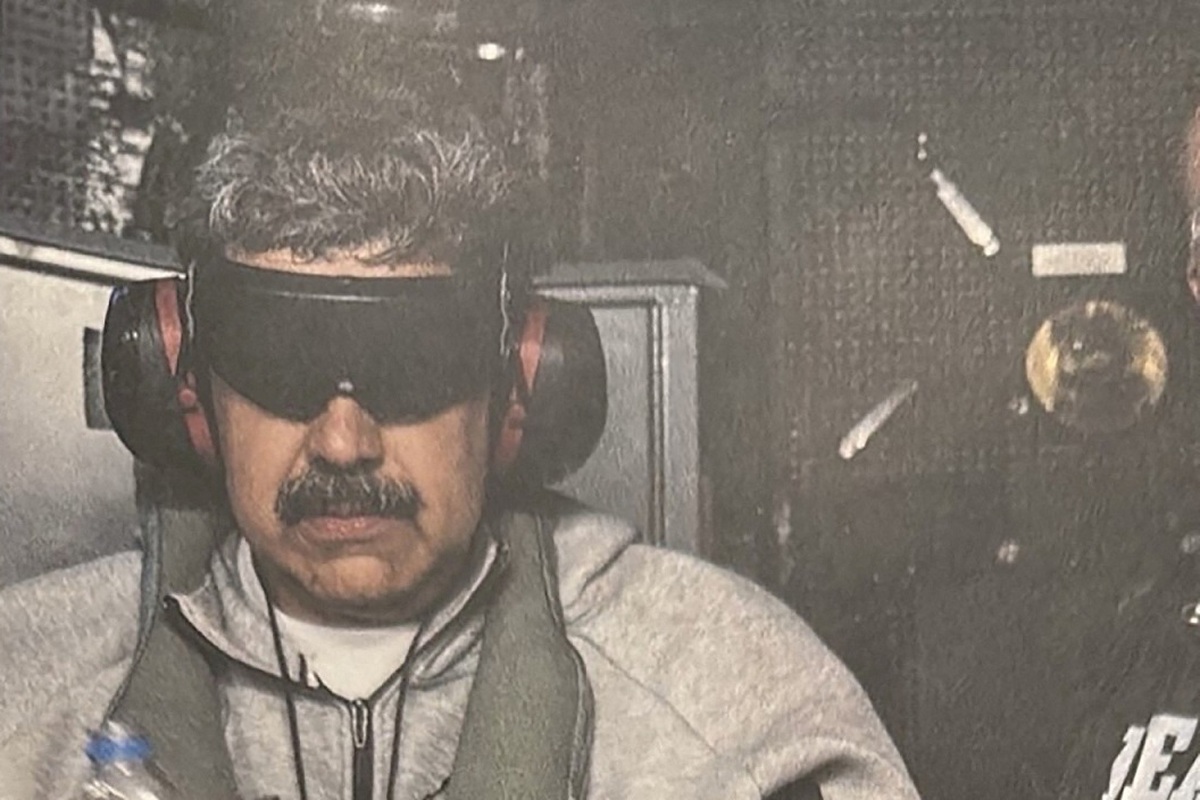

این مأموریت برای دستگیری مادورو و همسرش شامل بمباران چندین نقطه در کاراکاس در ماه گذشته بود. دستورالعملهای استفاده انتروپیک، استفاده از کلود برای تسهیل خشونت، توسعه سلاح یا انجام عملیات نظارتی را ممنوع میکند.

واکنش شرکتها و سکوت پنتاگون

سخنگوی انتروپیک گفت: «ما نمیتوانیم درباره اینکه آیا کلود یا هر مدل هوش مصنوعی دیگری در عملیات خاصی ـ طبقهبندیشده یا غیر آن ـ استفاده شده یا نه اظهار نظر کنیم. هرگونه استفاده از کلود، چه در بخش خصوصی و چه در دولت، باید مطابق سیاستهای استفاده ما باشد که نحوه استقرار آن را تعیین میکند. ما برای تضمین رعایت این مقررات با شرکای خود همکاری نزدیک داریم.»

وزارت دفاع آمریکا از اظهار نظر خودداری کرد.

همکاری با پالانتیر و نگرانیهای قراردادی

به گفته منابع، استقرار کلود از طریق همکاری انتروپیک با شرکت دادهای پالانتیر تکنولوژیز (PLTR با رشد ۱.۷۷ درصدی) انجام شد؛ شرکتی که ابزارهای آن بهطور گسترده توسط وزارت دفاع و نیروهای مجری قانون فدرال استفاده میشود. والاستریت ژورنال پیشتر گزارش داده بود نگرانیهای انتروپیک درباره نحوه استفاده پنتاگون از کلود باعث شده مقامهای دولت به بررسی لغو قرارداد تا سقف ۲۰۰ میلیون دلار فکر کنند. پالانتیر بلافاصله به درخواست اظهارنظر پاسخ نداد.

انتروپیک نخستین توسعهدهنده مدل هوش مصنوعی بود که توسط وزارت دفاع در عملیات طبقهبندیشده به کار گرفته شد. ممکن است ابزارهای هوش مصنوعی دیگر نیز در عملیات ونزوئلا برای وظایف غیرطبقهبندیشده استفاده شده باشند. این ابزارها از خلاصهسازی اسناد تا کنترل پهپادهای خودران کاربرد دارند.

رقابت شرکتهای هوش مصنوعی برای مشروعیت

پذیرش توسط ارتش بهعنوان یک تقویتکننده مهم برای شرکتهای هوش مصنوعی تلقی میشود که برای کسب مشروعیت رقابت میکنند و میکوشند ارزشگذاریهای عظیم سرمایهگذاران را توجیه کنند.

داریو آمودی، مدیرعامل انتروپیک، و دیگر مدیران ارشد بهطور عمومی با قدرت مدلهای خود و خطراتی که ممکن است برای جامعه ایجاد کنند دستوپنجه نرم کردهاند. آمودی برخلاف بسیاری از مدیران صنعت خواستار مقررات بیشتر و ایجاد حفاظهای کنترلی برای جلوگیری از آسیبهای هوش مصنوعی شده است. این شرکتِ متمرکز بر ایمنی و سایر شرکتهای صنعت کارمندانی را از دست دادهاند که گفتهاند رشد را بر توسعه مسئولانه فناوری ترجیح میدهند.

اختلاف با دولت ترامپ بر سر محدودیتها

در رویدادی در ژانویه که اعلام شد پنتاگون با شرکت xAI همکاری خواهد کرد، پیت هگست، وزیر دفاع، گفت این نهاد «از مدلهای هوش مصنوعی که اجازه جنگیدن ندهند استفاده نخواهد کرد»؛ اظهارنظری که به مذاکرات مقامهای دولت با انتروپیک اشاره داشت.

به گفته منابع، قرارداد ۲۰۰ میلیون دلاری تابستان گذشته به انتروپیک اعطا شد. آمودی بهطور علنی نسبت به استفاده از هوش مصنوعی در عملیات مرگبار خودکار و نظارت داخلی ابراز نگرانی کرده است؛ دو محور اصلی اختلاف در مذاکرات کنونی قرارداد با پنتاگون.

پیوند با اوپنایآی و چتجیپیتی نظامی

این محدودیتها تنش شرکت با دولت ترامپ را تشدید کرده است؛ از جمله اتهامهایی مبنی بر اینکه انتروپیک با درخواست حفاظهای بیشتر و محدودیت در صادرات تراشههای هوش مصنوعی، راهبرد کممقررات کاخ سفید را تضعیف میکند.

آمودی و دیگر همبنیانگذاران انتروپیک پیشتر در اوپنایآی کار میکردند؛ شرکتی که اخیراً همراه با «جمنای» گوگل در یک پلتفرم هوش مصنوعی برای نیروهای نظامی ـ مورد استفاده حدود سه میلیون نفر ـ قرار گرفته است. این شرکت و وزارت دفاع اعلام کردند نسخه سفارشی چتجیپیتی برای تحلیل اسناد، تولید گزارش و پشتیبانی پژوهش به کار خواهد رفت.

منبع: والاستریت ژورنال